마르코프 체인 (Markov Chain) 정의 및 사례

마르코프 체인이란 한 상태(State)에서 다른 상태로 이전을 할때 특정한 확률적인 특성을 따르는 것을 의미하는데, 마르코프 체인을 대표하는 가장 중요한 성질은 현재 상태에서 다음 상태로 넘어갈때 현재 시점보다 이전의 과거 상태에는 의존을 하지 않는 다는 것이다. 추상적으로 느껴지는 개념이지만 사실 사례를 통해서 살펴보면 꽤나 간단한 원리이고, 이 특성을 이용하면 복잡한 Joint Distribution을 계산을 손쉽게 할 수 있다. 강화 학습을 공부하거나 베이지안 통계학을 공부하면 이 마르코프 체인(Markov Chain)이라는 개념이 많이 등장하는데, 흔히 쓰이는 MCMC (Markov Chain Monte Carlo)를 이해하는 것에도 필수적인 개념이다.

랜덤 변수(Random Variable) 의 일반적인 Joint Distribution

랜덤변수들 $ X_1, X_2, ... X_n$ 이 있다고 가정을 하자. 그 변수들 의 Joint Distribution은 아래와 같이 계산을 할 수 있다.

$$P(X_1, ... X_n)=P(X_1)\times P(X_2|X_1)\times P(X_3|X_2,X_1)...\times P(X_n|X_{n-1},X_{n-2}....X_1)$$

마르코프 체인의 특성을 통한 Joint Distribution 계산

어떠한 한 상태의 시점을 t라고 하고, 확률 분포가 마르코프 체인의 특성(Markov Property)를 따른다고 하면,

$$P(X_{t+1}|X_t,X_{t-1}, ...X_2, X_1)=P(X_{t+1}|X_t)$$로 단순화 할 수 있고, 일반화를 통해서 위 Joint Distribution의 계산을 아래와 같이 단순화 할 수 있다.

$$P(X_1,X_2,...X_n)=P(X_1)\times P(X_2|X_1)\times P(X_3|X_2) \times P(X_4|X_3) ... P(X_n|X_{n-1})$$

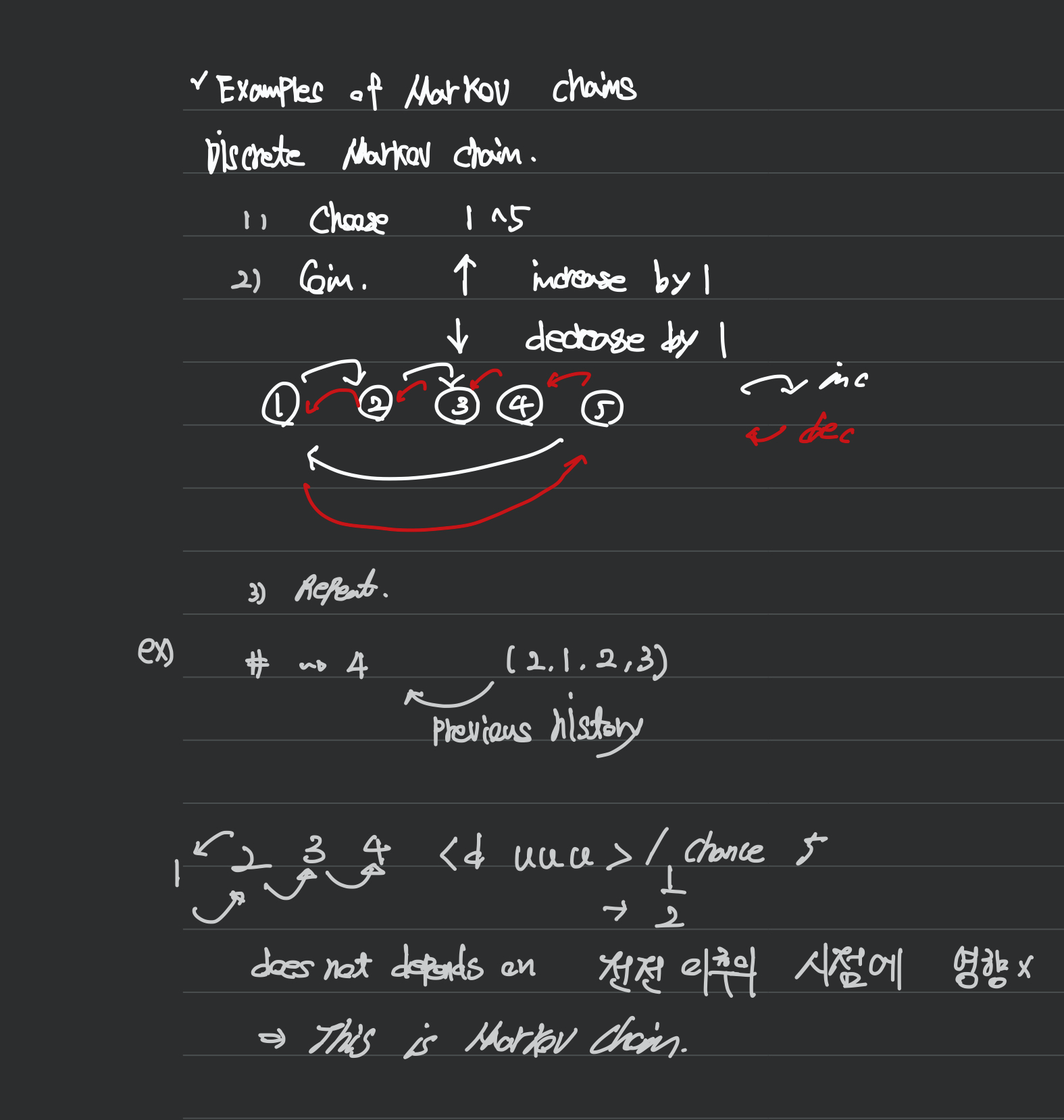

이산확률 변수의 사례

간단한 동전던지기의 사례를 예를 들어보자. 1~5 중에 동전을 하나 고른다고 하고, 윗 면이 나오면 하나를 증가하고 아랫 면이나오면 하나씩 감소를 한다고 하자. 우리가 이전에 2로 출발해서 2->1->2->3 이라는 상태에서 다음 단계에 4가 나올 확률은 어떻게 될까? 이것은 우리의 이전의 상태들의 기록(History)에 영향을 받을까? 결과는 당연히 아니다. 동전을 던져서 현재 3이라는 상태에서 4로 가는 것에는 확률이 1/2인 하나의 경우 밖에 되지 않는다. 이런 사건들을 우리는 마르코프 체인을 따르는 사건이라고 한다.

연속 확률변수의 사례 Random Walk

연속확률변수 X가 아래의 분포를 따르는 아주 단순한 경우를 가정해보자.

$$P(X_{t+1}|X_t=x_t)=N(x_t,1)$$

이 경우도 이산 확률변수의 경우와 마찬가지로 이전 단계의 value가 mean이 되고 Variance가 1 이 되는 분포를 따른다. X_{t+1}의 분포는 t단계 이전의 상태에서는 영향을 받지 않는데, 흔히 이런 경우를 우리는 "Random Walk"라고 언급을 한다 (e.g. 주식시장).

참고자료:

댓글